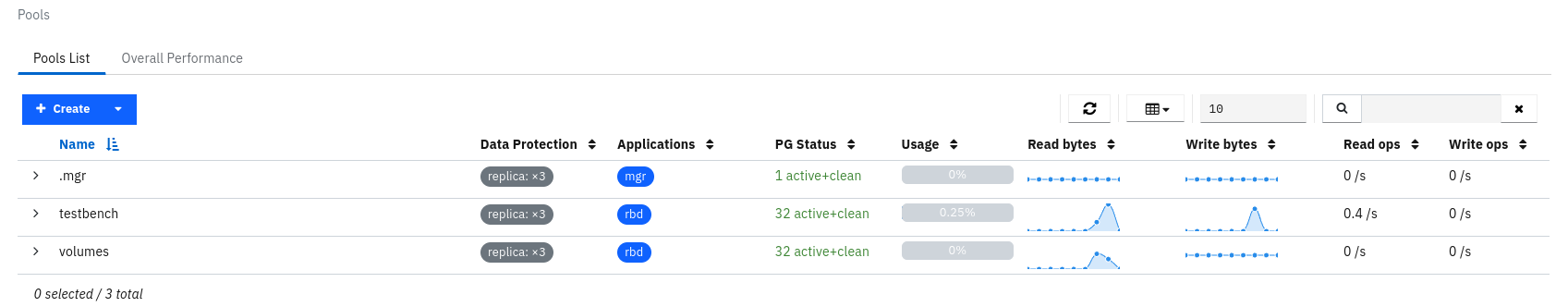

Ceph Storage의 Block Device (RBD) 에 대한 성능 테스트 방법입니다. 1. pool 생성rbd을 지원하는 pool 생성 또는 기존 pool에 rbd 타입을 추가한다. 2. pool 에 image 생성 3. image 쓰기 성능 테스트 [ceph: root@cnode1 /]# rbd bench --io-type write image01 --pool=testbenchbench type write io_size 4096 io_threads 16 bytes 1073741824 pattern sequential SEC OPS OPS/SEC BYTES/SEC 1 6256 4850.97 19 MiB/s 2 6448 3178.13..